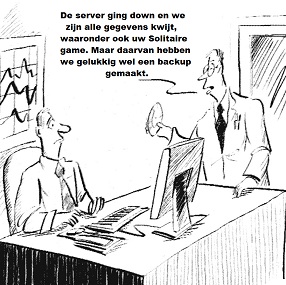

Toen de redactie van het tijdschrift Informatieprofessional (IP) mij vroeg om voor het oktobernummer mijn licht eens te laten schijnen op de juridische implicaties van ‘cloud computing’ werd ik gestimuleerd om weer eens wat literatuuronderzoek en webresearch te doen. Wetende dat ‘cloud computing’ een enorme vlucht aan het nemen is, is het de moeite waard eens in beeld te brengen wat het begrip betekent en welke implicaties dat heeft voor de wereld om ons heen. We hebben immers de mond vol van ‘cloud computing’, van Web 2.0. en van het semantische web. Op het moment dat ik mijn manuscript bij de redactie had ingediend, besteedde De Financiële Telegraaf kort aandacht aan het verschijnsel, en dan met name aan de risico’s die het met zich meebrengt en de nieuwe regelgeving die nodig zou zijn. Of dat nodig is laat ik in het midden; zeker is, dat er (naast baten) veel risico’s zijn.

Bij de term ‘cloud computing’ komt bij mij altijd The Big Switch. Rewiring the world, from Edison to Google van Nicholas Carr voor de geest. Niet omdat het een geniaal boek is (want dat is het niet), maar wel om de levendige en enthousiaste beschrijving van de wonderen en gevaren van het Internet, de ‘World Wide Computer’, zoals Carr het noemt. Het is een vreemd boek, dat eigenlijk niet over ‘cloud computing’ gaat, maar het toch beschrijft. Het bestaat uit twee delen, die weinig gemeen hebben, behalve dat ze over het Internet en daaraan gerelateerde verschijnselen gaan. In het eerste deel (blz. 5-103) beschrijft Carr de geschiedenis van elektriciteit en van computers en vergelijkt daarbij de ontwikkeling die daarbij werd doorgemaakt, van een technologisch beperkt, lokaal gebruik tot een snel gecentraliseerd netwerk van verbindingen. Zowel elektriciteit als computers veranderden de manieren waarop we leven, met elkaar omgaan en zaken afhandelen. De gebruikte metafoor stelt Carr in staat om te stellen dat het Internet, door de integratie die het genereert, de aanleiding is van de wisseling van het lang gebruikte client-servermodel naar, wat hij noemt, ‘utility computing’. ‘Utility computing’ wordt, zo zegt Carr, net zoals de elektrische stroom vooral gefaciliteerd door de ontwikkelingen in netwerktechnologie. In een dergelijke omgeving fungeren sommige bedrijven als ‘utilities’, die enkel een platform bieden waarop andere partijen toepassingen ontwikkelen. Gebruikers kunnen die platformen snel en tegen lage kosten benutten om daarop snel allerlei toepassingen aan hun klanten als dienst aan te bieden. In dit deel van The Big Switch beschrijft Carr ‘cloud computing’ in optima forma. In het tweede deel van zijn boek (blz. 105-232) schrijft Carr over allerlei aspecten, die de ‘World Wide Computer’ bepalen en de dreigingen, die daaruit voortvloeien (bijvoorbeeld voor de privacy van de gebruikers). Hoewel zeer lezenswaardig hebben deze hoofdstukken vreemd genoeg weinig te maken met het verschijnsel ‘cloud coumputing’, zoals dat in het eerste deel zo enthousiast is gepresenteerd.